Nokia N900 und Maemo 5

Jetzt bin ich also pünktlich zum Ende des Jahres auch in der Smartphone-Welt angekommen und es war abzusehen, dass nur ein Linux-unterstützendes Handy in Frage kommen konnte.

Da mir jedoch Android in seiner Oberfläche zu eingeschränkt schien und ich auch nicht unbedingt auf die Mainstream-Gleise springen wollte kam für mich als Alternative nur das Nokia N900 mit der Nischen-Dstribution Maemo 5 in Frage.

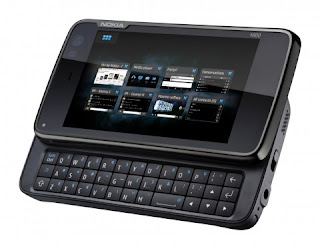

Ein Mitgrund für diese Entscheidung war auf jedenfall vor allem die aufschiebbare mechanische Tastatur, da ich auf ein zu häufiges Getatsche auf dem integrierten Touchscreen verzichten kann. Auf jedenfall bietet es aber auch ein sehr schickes Design und fasziniert mit seiner Fülle an Funktionen und informationstechnischen Möglichkeiten. Aber erstmal eins nach dem Anderen.

Gehäuse

Das Gerät wird in einem standardisierten schwarzen Kunststoffgehäuse geliefert inklusive einem 4,4" Touchscreen. Es wirkt durch seine feine Verarbeitung und den sauber ausgefrästen Umrundungen sehr edel und hat wie schon erwähnt eine mechanische Tastatur mit doppelt gessetzter Bezifferung mitgeliefert. An den Seiten sind Öffnungen für die Schnittstellen Micro-USB und auf der entgegengesetzten Seite eine AV-Cinch-Buchse. Ansonsten sind noch an beiden Seiten Lautsprecheröffnungen angebracht, die auch eine räumlich ansprechende Klangatmosphäre bieten.

Eine weitere positive Eigenschaft ist auch die 5 Megapixel-Autofokus-Kamera mit Optik von Carl Zeiss und zwei LED-Blitzlichtern, die auf Verschlussseite noch einen Infrarotsensor beinhaltet, der die Hardware informiert, dass beim Öffnen in den Foto-Modus umgeschaltet werden soll. Um vorzubeugen, dass zu häufig mit dem Finger über den Touchscreen gefahren werden muss ist ausserdem noch ein Stift enthalten mit welchem der Touchscreen optional angesteuert werden kann - im Gegensatz zu so einigen anderen mir bekannten Smartphones.

Negativ am Gehäuse ist mir jedoch die Umständlichkeit aufgefallen mit welchem sich der Akku entfernen und der Zugriff zu SIM- und SD-Karte freigelegt wird. Erst nachdem ich mein Schweizer Taschenmesser zur Hilfe genommen habe ließ sich die hintere Abdeckung entfernen und ich konnte mir den dort befindlichen Akku mal näher ansehen.

Hardware

Auf Hardware-Seite ist wie bereits erwähnt eine Micro-USB-Buchse enthalten mit denen sich das Smartphone problemlos an jedes Betriebssystem andocken lässt und auch für jedes Betriebssystem externe Flash-programme bezogen werden können mit denen Updates und anderweitige Software eingespielt werden kann. Die Hintergrundbeleuchtung ist über 5 Graustufen regulierbar, jedoch das Display sieht mit seiner 16 Bit Farbtiefe etwas matt aus. Erfreulich ist auch, dass an den Seiten ein Umgebungslichtsensor, ein Abstandassensor und ein Drehwinkelsensor angebracht sind, die auch für eine freie Programmierung eigener Widgets (Apps) und anderweitiger Funktionalitäten verwendet werden können. Mit einem 32GB internem EEPROM-Speicher lässt sich auch noch so einiges an Daten unterbringen. Zusätzlich können noch bis zu 16 GB mittels micro-SD-Karte an der Hinterseite des Gehäuses angebracht werden. Es kann mit allen gebräuchlichen Frequenzbänder gefunkt und Daten übertragen werden, welche sind:

GSM, UMTS, HSPA, EDGE, WLAN, GPS sowie Bluetooth

Negativ ist mir jedoch aufgefallen, dass die Akkulaufzeit nicht sonderlich lange hält. Es ist zwar verständlich, dass durch eine ausgiebige Internetnutzung und eine zeitbeanspruchendes Arbeiten mit dem Gerät die Laufzeit sich drastisch verkürzt, aber dass selbst im Standby-Modus fast alle 2 Tage ein Nachladen nötig ist enttäuscht ein wenig. Jedoch lässt sich aufgrund der Offenheit des Systems und dem vorinstallierten Funktionsumfang darüber hinwegsehen.

Software

Der eigentliche Clue jedes Smartphones bietet natürlich die Software und wie bereits erwähnt ist hier die Linux-Distribution Maemo 5 enthalten, welche mit einer übersichtlichen KDE-Oberfläche ankommt und auch schon einige Programme mitbringt. Der Desktop ist über 4 Bereiche gegliedert und lässt sich im Touchscreen beliebig verschieben. Im Menü sind alle nötigen Informationen zu finden, sowie ein Dateimanager und ein Programmmanager.

Für die Social Communities Twitter, Facebook sowie für Google sind bereits Widgets auf dem Desktop abgelegt. Mit einem Klick darauf öffnet sich ein auf Firefox basierender Browser mit dem gemütlich mittels mechanischer Tastatur und dem Stift als Maus im Internet gesurft werden kann. Im Menü ist sogar eine Linux-Shell enthalten mit denen sich das ganze System noch konfigurieren lässt.

Jedoch war es relativ schwer darauf zu kommen wie man sich als Root einloggt, denn bei einem ständigen Versuch bestimmte Dateien zu öffnen wurde gemeckert, dass man nicht privilegiert dazu sei.

Am Ende stellte sich fest, dass aus dem Internet ein Programm namens Roothsh heruntergeladen werden muss und extern auf dem Gerät installiert werden mit dem lässt sich mittels des Befehls

passwd

das vorinstallierte root-Passwort ändern.

Ein weiterer Nachteil ist meiner Meinung nach auch, dass sich die Breite der Widget nicht verändern lassen und man diese wohl oder übel vorerst von Herstellerseite so akzeptieren muss. Da im Endeffekt alle Widgets jedoch auf HTML, CSS und JavaScript zurückzuführen sind ließen sich diese eigentlich auch ohne weiteres im Editor nach belieben anpassen mit einigen Vorabkentnisse. Nur mit dem Layout der ".jpg"-Dateien hätte man möglicherweise ein Problem...

Sehr interessant finde ich auch die Tatsache, dass neben der Distribution Maemo 5 auch noch die Distribution Meego installiert werden kann. Da es sich heirbei um eine ursprünglich für Notebooks und Desktoprechner konzipierte Distribution handelt werde ich gespannt über die Ergebnisse sein sobald ich zu diesem Schritt komme.

Doch vorab werde ich mal versuchen einige Programme für dieses tolle Schmuckstück selber zu schreiben und die enthaltenen Sensoren auch zu nutzen - mal sehen was sich dadurch für lustige Spieler oder sogar zweckmäßige Möglichkeiten zaubern lassen. Eine Entwicklungsumgebung für Maemo 5 stellt Nokia übringens öffentlich im Internet zur Verfügung und kann hier heruntergeladen werden.

Fazit

Alles in allem bereue ich meine Entscheidung zu diesem Gerät keinesfalls. Es ist wirklich ein tolles Smartphone mit bereits einer Menge nützlicher vorinstallierter Funktionen und die Möglichkeit selber Hand an der internen Struktur des Gerätes zu legen und noch so einiges rauszuholen begeistert mich nur um so mehr von der Technik. Bislang stelle ich auch noch keine Mängel fest und vermisse auch keine Funktionalität. Jedoch tat ich mich am Anfang schwer mich an dieses Gerät zu gewöhnen, da man etwas überfordert wird mit dem gelieferten Funktionsumfang.

Was etwas negativ auffiel war jedoch der Update-Manager, der sich zuerst schwer Tat Zugriff zum Nokia-Server zu erhalten um von dort ein Update auf die neuste Version zu bekommen, doch nach einiger Wartezeit ging auch diese Sache. Ich denke, dass hier auch nicht das Handy daran Schuld war sondern eher ein Server-Ausfall, da ich mich im Allgemeinen zur Zeit schwer tue auf die offizielle Maemo-Seite zu gelangen. Wollen wir mal hoffen, dass sich das noch ändert, denn dann bieten sich unbegrenzte Möglichkeiten.